N'importe quelle femme peut aujourd’hui apparaître virtuellement dans une photo ou une vidéo pornographique sans jamais y avoir participé. Face à cette menace, l’union européenne tente de mettre en place une loi pour criminaliser cette pratique.

La manipulation d'images et de vidéos pour créer des contenus à caractère sexuel est sur le point d'être considérée comme une infraction pénale dans tous les pays de l'Union européenne.

La première directive sur la violence à l'égard des femmes passera par la phase d'approbation finale en avril 2024.

Ces montages photo ou vidéo hyperréalistes sont en général illégaux, et peuvent ruiner la réputation et la vie des personnes dont ils s'accaparent l'image. Les victimes voient la diffusion de ces contenus se propager sur des plateformes en ligne. Il est difficile de mettre fin à la propagation de deepfakes.

Mais qu'est-ce qui va changer avec cette nouvelle directive ? Et que se passera-t-il si des femmes vivant dans l'Union européenne sont victimes de manipulations effectuées dans des pays extérieurs à l'Union européenne ?

Les victimes sont toujours des femmes

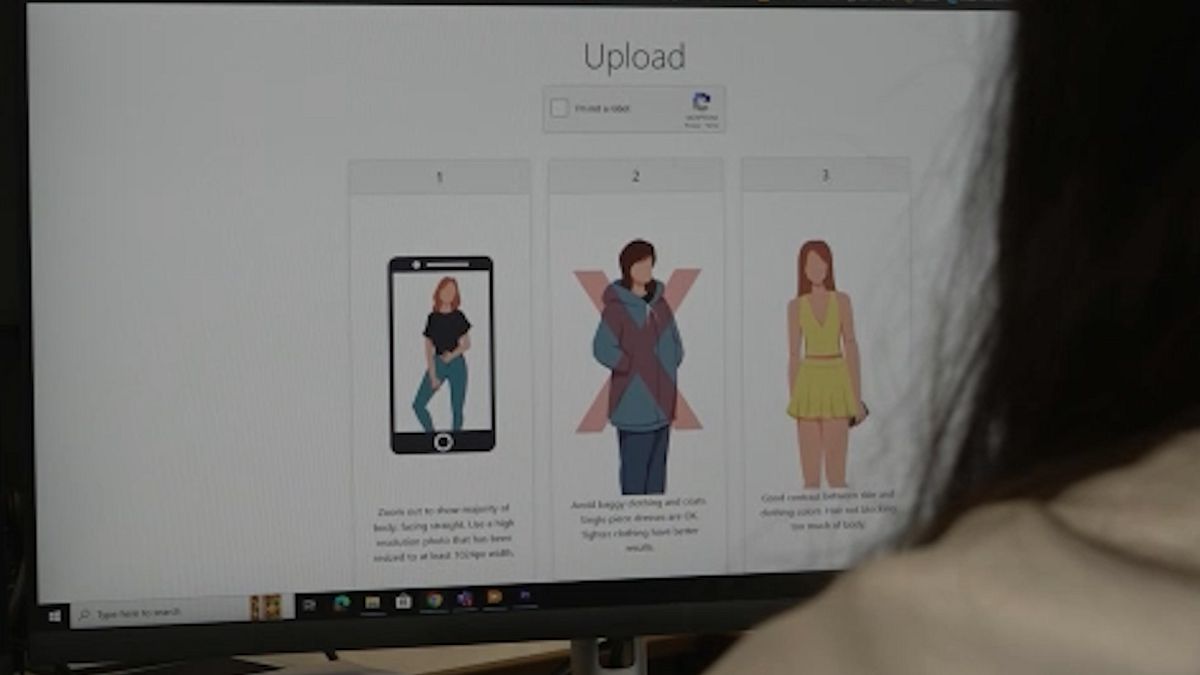

Les sites web qui permettent de créer des "deepfakes" sexuels sont à portée de clic sur n'importe quel moteur de recherche et sont gratuits de surcroît.

La création d'un deepfake sexuel prend moins de 25 minutes et ne coûte rien, en utilisant uniquement une photographie sur laquelle le visage est clairement visible, selon l'étude 2023 State of Deepfakes.

Sur un échantillon de plus de 95 000 vidéos de deepfakes analysées entre 2019 et 2023, l'étude a révélé une augmentation de ces contenus de 550%.

Selon Henry Ajder, expert en intelligence artificielle et en deepfakes, ceux qui utilisent ces outils cherchent à "diffamer, humilier, traumatiser."

"Il est important de noter que ces outils de déshabillage ne fonctionnent pas sur les hommes. Ils sont spécifiquement conçus pour cibler les femmes. C'est un bon exemple de technologie clairement malveillante. Elle n'a rien de neutre", ajoute-t-il.

Les créateurs de deepfakes pornographiques recherchent les photos de leurs victimes "partout et n'importe où".

"_Elles peuvent provenir de leur compte Instagram, de leur compte Facebook, de leur photo de profil WhatsAp_p", explique Amanda Manyame, consultante en droits numériques et en droit à Equality Now.

Lacybersécurité n'est pas au niveau

Lorsque les femmes tombent sur des "deepfakes" les mettant en scène, la question de la prévention se pose.

Selon une experte en cybersécurité, la réponse n'est pas tant dans la prévention, mais dans l'action rapide pour pouvoir les supprimer.

"Je constate que lorsqu'un incident de ce type se produit dans le domaine numérique, les gens disent qu'il ne faut pas mettre ses photos en ligne, mais c'est la même logique que de dire qu'il ne faut pas sortir dans la rue pour ne pas avoir d'accident", explique Rayna Stamboliyska.

"Malheureusement, la cybersécurité ne peut pas être d'un grand secours dans ces cas-là, car il s'agit de démanteler le réseau de diffusion et de supprimer le contenu en même temps", ajoute l'experte en cybersécurité.

Actuellement, les victimes de "deepfakes" pornographiques s'appuient sur une série de lois telles que la loi sur la protection de la vie privée de l'Union européenne, le règlement général sur la protection des données et les lois nationales sur la diffamation pour se protéger.

Lorsqu'elles sont confrontées à ce type d'infraction, il est conseillé aux victimes de faire une capture d'écran ou un enregistrement vidéo du contenu et de l'utiliser comme preuve pour le signaler à la plateforme de médias sociaux elle-même et à la police.

La consultante en droits numériques et en droit d'Equality Now ajoute : "Il existe également une plateforme appelée StopNCII, ou Stop Non-Consensual Abuse of Private Images, sur laquelle vous pouvez signaler une image de vous et le site web crée alors ce que l'on appelle un 'hash' (mot anglais signifiant 'haché') du contenu. Avec l'aide de l'IA, il supprime automatiquement le contenu sur différentes plateformes."

Une problématique mondiale

Avec cette nouvelle directive proposée pour lutter contre la violence à l'égard des femmes, les 27 États membres disposeront du même ensemble de lois pour criminaliser les formes les plus diverses de cyber violence, telles que les "deepfakes" pornographiques.

Cependant, le signalement de ce type d'infraction peut s'avérer compliqué.

"Le problème, c'est qu'une victime peut vivre à Bruxelles. Le criminel se trouve en Californie, aux États-Unis, et le serveur qui contient le contenu peut se trouver, disons, en Irlande. Il s'agit donc d'un problème mondial, car nous avons affaire à différents pays", explique Amanda Manyame.

Face à cette situation, l'eurodéputée suédoise de centre-gauche , Evin Incir, explique que "ce qu'il faut faire en parallèle de la directive", c'est renforcer la coopération avec les autres pays, "car c'est la seule façon de lutter contre cette criminalité qui ne connaît pas de frontières".

"Malheureusement, la technologie de l'IA se développe très rapidement, ce qui signifie que notre législation doit également suivre. Nous devrions donc bientôt réviser la directive à ce sujet. Il s'agit donc d'une étape importante pour l'état actuel des choses. Mais nous devrons suivre le développement de l'IA." A ajouté Evin Incir.