L'IA fait désormais de la télé, souvent pour propager de fausses informations. Mais dans des cas limités, notamment dans des régimes répressifs, ces outils aident à libérer les journalistes indépendants, qui veulent diffuser des informations fiables, des dangers liés à l'exposition publique.

"Le Canada a déclaré la guerre aux États-Unis d'une manière stupéfiante", déclare une présentatrice américaine blonde dans une vidéo diffusée sur les réseaux sociaux, de TikTok à X.

PUBLICITÉ

PUBLICITÉ

PUBLICITÉ

PUBLICITÉ

Regardant droit dans la caméra, la journaliste poursuit : "Allons voir Joe Braxton, qui vit à la frontière".

Mais ceux qui parviennent à la septième seconde de la vidéo ont le plus de chances de se rapprocher de la vérité.

"Je suis actuellement à la frontière, mais il n'y a pas de guerre", explique un correspondant avant de révéler : "Maman, papa, je sais que cela peut sembler réel, mais tout cela est le fruit de l'intelligence artificielle, mais tout cela est le fruit de l'intelligence artificielle".

Bien que les présentateurs dans ces extraits semblent faire preuve du même enthousiasme, de la même énergie et de la même diction que de nombreux vrais journalistes, ils sont générés par l'intelligence artificielle (IA).

La plupart de ces vidéos sont créées à l'aide de Veo 3, le logiciel de génération vidéo basé sur l'IA de Google, qui permet aux utilisateurs de créer des vidéos sophistiquées de huit secondes, en synchronisant parfaitement l'audio et la vidéo.

Grâce à cette technologie, les utilisateurs poussent ce logiciel à faire dire des choses insensées à de faux présentateurs de journaux télévisés.

Comment reconnaître que ces vidéos sont fausses ?

Un certain nombre de conseils peuvent aider les internautes à déterminer si une vidéo avec un présentateur de télévision d'apparence légitime est réelle ou non.

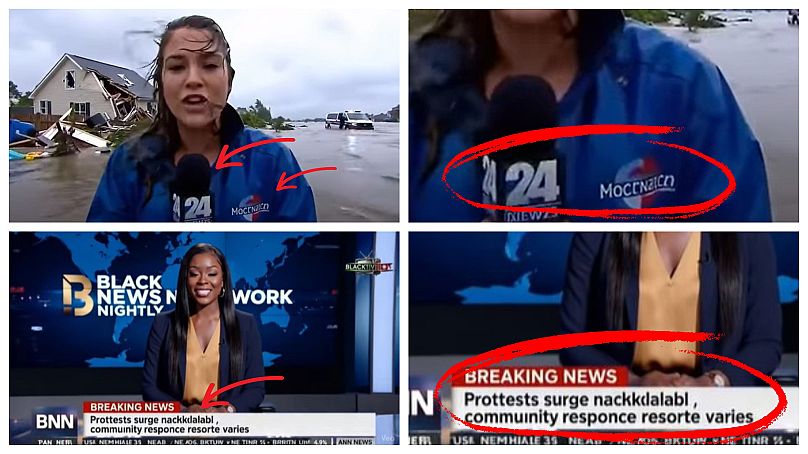

Un indice révélateur est le fait que dans ces vidéos, de nombreux "correspondants" qui semblent être en duplex sur le terrain tiennent le même micro, sur lequel figure le terme générique "NEWS" ("ACTUALITÉS").

En réalité, bien que de nombreuses chaînes de télévision aient le terme "NEWS" quelque part dans leur nom (par exemple, BBC News, Fox News ou Euronews), aucune grande chaîne n'est simplement appelée "News".

Dans d'autres cas, les logos affichés sur les micros, les carnets, les vêtements des présentateurs, ainsi qu'en arrière-plan et à l'écran, sont incompréhensibles.

L'IA n'est pas en mesure de distinguer ce qui rend une série de lettres lisible, car elle se concentre principalement sur les motifs visuels plutôt que sur la sémantique du texte. En conséquence, elle génère fréquemment du texte illisible.

Cela s'explique par le fait que l'IA fonctionne à partir d'une invite. Ainsi, si une personne saisit une invite qui ne précise pas quels mots doivent être inclus dans la vidéo générée, la machine générera son propre texte.

Les Deepfake utilisés par les États

Ces dernières années, de plus en plus de chaînes de télévision authentiques ont expérimenté des lecteurs d'informations basés sur l'IA, soit par le biais de présentateurs entièrement générés par l'IA, soit en demandant à de vraies personnes d'autoriser leur image ou leur voix.

En octobre, une station de radio polonaise a suscité la controverse après avoir licencié ses journalistes et relancé ses programmes avec des "présentateurs" IA.

Cependant, les acteurs étatiques ont également utilisé l'IA pour colporter de la propagande.

Par exemple, dans un rapport publié en 2023, la société d'analyse d'IA Graphika a révélé qu'un média fictif nommé "Wolf News" faisait la promotion des intérêts du Parti communiste chinois à travers des vidéos diffusées sur les réseaux sociaux, commentées par des présentateurs générés par IA.

Quand les présentateurs de l'IA contournent la censure répressive

Bien que les présentateurs d'IA puissent accroître la diffusion de fausses nouvelles et de désinformation, ils peuvent dans certains cas libérer les journalistes qui vivent dans des régimes répressifs des dangers liés à l'exposition publique.

En juillet 2024, le dirigeant vénézuélien Nicolas Maduro a été réélu lors d'une élection très contestée, entachée de fraudes, selon des groupes de défense des droits de l'homme.

À la suite de sa réélection, Maduro, au pouvoir depuis 2013, a intensifié la répression contre la presse, mettant en danger les journalistes et les professionnels des médias.

Pour riposter, les journalistes ont lancé l'Operación Retuit (Opération ReTweet) en août 2024.

Dans une série de 15 vidéos percutantes, inspirées des réseaux sociaux, "Bestie" et "Buddy", présentateurs créés par l'IA, font le point sur la situation politique au Venezuela et partagent des preuves factuelles.