Un flux en temps réel d'images et de vidéos générées par l'IA de la capture du président vénézuélien Nicolás Maduro par les forces américaines samedi a été partagé par des personnalités publiques et a recueilli des millions de vues dans toute l'Europe.

Peu après que le président américain Donald Trump a annoncé une "frappe à grande échelle" sur le Venezuela samedi, les réseaux sociaux européens ont été inondés d'images trompeuses, générées par l'IA, de la capture de Nicolás Maduro et de vidéos de Vénézuéliens célébrant celle ci dans le monde entier.

PUBLICITÉ

PUBLICITÉ

PUBLICITÉ

PUBLICITÉ

Sur TikTok, Instagram et X, les images générées ou modifiées par l'IA, les anciennes séquences transformées en nouvelles séquences et les vidéos hors contexte ont proliféré.

Nombre d'entre elles ont accumulé des millions de vues sur les différentes plateformes et ont été partagées par des personnalités publiques, dont Trump lui-même, le propriétaire de X, Elon Musk, le fils de l'ancien président brésilien, Flávio Bolsonaro, et le compte officiel du parti de droite portugais Chega.

Seloncertains experts , il s'agit de l'un des premiers incidents au cours duquel des images IA d'une personnalité politique majeure ont été créées en temps réel, au fur et à mesure de l'évolution de l'actualité.

Mais pour d'autres, ce n'est pas l'ampleur de cette vague de fausses informations qui est unique, mais le fait que tant de personnes - y compris des personnalités publiques - soient tout bonnement tombées dans le panneau.

Image créée par l'artiste AI floods platforms

Le 3 janvier, les forces spéciales américaines ont capturé l'ancien dirigeant du Venezuela et son épouse lors d'une opération éclair. Nicolás Maduro est accusé de trafic de drogue au niveau fédéral et a plaidé non coupable.

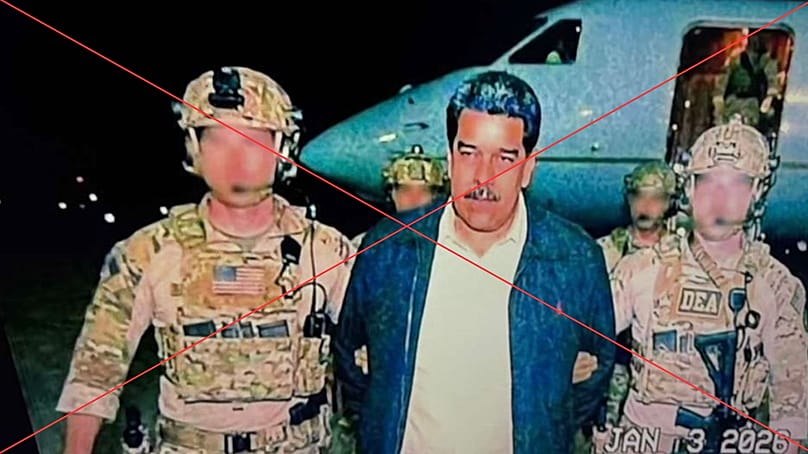

Peu après sa capture, de nombreuses images de Nicolás Maduro sont apparues sur les réseaux sociaux. L'équipe de vérification des faits d'Euronews, Le Cube, a trouvé des exemples de l'image ci-dessous partagée en espagnol, en italien, en français et en polonais.

Une image de Maduro débarquant d'un avion a été partagée par le compte officiel du parti d'extrême droite portugais Chega, ainsi que par le fondateur du parti, André Ventura, et d'autres membres du parti. Elle a également été présentée par plusieurs médias en ligne comme une photo réelle.

Alors que l'image se propageait rapidement en ligne, les vérificateurs de faits ont remarqué que lorsque la photo était passée par l'outil de vérification SynthID de Gemini, elle contenait des filigranes numériques indiquant que tout ou partie de l'image avait été générée ou modifiée par l'IA de Google.

L'analyse de Google Gemini a révélé que "la majeure partie ou la totalité (de l'image) a été générée ou modifiée avec Google AI".

Selon Detesia, une start-up allemande spécialisée dans la technologie de détection des hypertrucages ou "deepfakes", ses modèles d'IA ont trouvé des "preuves substantielles" que l'image avait été générée par l'IA."

Detesia a indiqué que la photo originale avait suscité plusieurs photos similaires, d'une portée plus modeste sur les médias sociaux, qui contenaient également des artefacts visibles du filigrane SynthID. Les versions ultérieures présentaient des signes évidents de génération d'IA, notamment des images de soldats à trois mains et des images représentant Nicolás Maduro couvert de sang.

L'image, qui est très probablement générée par l'IA, a été vue des millions de fois sur les plateformes de médias sociaux, y compris un post X espagnol qui a été vu 2,6 millions de fois à lui seul.

Selon Tal Hagin, analyste de la guerre de l'information et conférencier en éducation aux médias, les progrès rapides de la technologie de l'IA rendent encore plus difficile l'identification des "deepfakes".

"Nous n'en sommes plus au stade où il faut attendre six mois, nous y sommes déjà : nous sommes incapables d'identifier ce qui relève de l'IA et ce qui n'en relève pas."

Au lendemain de la capture de Nicolás Maduro, les individus disposaient de peu de détails et en particulier d'aucune image, "lorsque vous avez ce vide d'informations, il doit être comblé d'une manière ou d'une autre", a déclaré Tal Hagin.

"Des personnes ont commencé à télécharger des images générées par l'IA de Maduro détenu par les forces spéciales américaines afin de combler cette lacune", a-t-il conclu.

Une autre image, qui a été visionnée plus de 4,6 millions de fois, prétend montrer Nicolás Maduro assis dans un avion-cargo militaire en pyjama blanc.

Newsguard, une plateforme américaine qui surveille la fiabilité des informations, a indiqué que l'image présentait des signes évidents de génération d'IA, notamment une double rangée de fenêtres de sièges passagers.

Elle contredit également les preuves : Nicolás Maduro a été transporté hors du Venezuela par hélicoptère jusqu'à un navire de la marine américaine, dont aucun ne semble avoir une double rangée de fenêtres comme sur l'image.

Vidéos de manifestants montées par l'IA ou sorties de leur contexte

Peu après la diffusion de fausses images de l'arrestation de Nicolás Maduro, les plateformes de réseaux sociaux ont été inondées d'images de manifestants célébrant sa capture.

Certaines d'entre elles, dont une partagée par Musk montrant des Vénézuéliens pleurant de joie, ont été visionnées plus de 5,6 millions de fois. Les signes de la génération d'IA comprennent des mouvements humains non naturels, des teintes de peau et des plaques d'immatriculation anormales sur les voitures.

Les dépêches en provenance du Venezuela indiquent que l'humeur du public etait beaucoup plus complexe, une catégorie de la population exprimant de la joie et de l'espoir après la capture de Maduro, ainsi que de la peur et de l'incertitude quant à ce que pourrait être la transition du pouvoir. D'autres ont condamné l'intervention des États-Unis dans leur pays.

De nombreuses vidéos sont apparues avec des légendes trompeuses sur des vidéos de protestation. Une vidéo partagée sur X, qui a accumulé plus d'un million de vues, a été diffusée le 4 janvier avec la légende suivante : "Voici Caracas aujourd'hui. Des foules immenses soutiennent Maduro".

En réalité, cette vidéo provient d'une marche à laquelle Maduro et ses jeunes partisans ont participé au Palais de Miraflores à Caracas en novembre 2025.

Une autre vidéo largement partagée sur X en français montre un homme sur un balcon qui tend un téléphone vers une foule de personnes avec la légende suivante : "J'ai rarement vu un peuple aussi heureux que les Vénézuéliens d'être enfin débarrassés de Maduro grâce à l'intervention américaine." Des feux d'artifice sont visibles en arrière-plan.

Selon Tal Hagin, plusieurs indices permettent de douter de l'authenticité de la vidéo, notamment le fait que les feux d'artifice semblent provenir de la foule et qu'ils ne produisent pas un niveau de fumée approprié. L'image affichée sur le téléphone ne correspond pas non plus à la foule qui se trouve en dessous.

Selon Tal Hagin, le danger de ce volume d'images générées par l'IA est qu'il crée dans l'esprit des gens une fausse impression d'antécédents, "si j'ai vu cinq exemples différents de Maduro en garde à vue dans des tenues différentes, c'est qu'ils sont tous faux".

"I_l y a des vidéos qui sont 100% réelles, sans aucune raison de les mettre en doute, et les gens continuent de dire que c'est de l'IA parce qu'ils ne veulent pas que ce soit vrai_", a ajouté Tal Hagin.

"Il faut du temps pour vérifier les informations, s'assurer que ce que l'on dit est correct, et pendant que l'on essaie de vérifier cette vidéo, les gens diffusent de plus en plus d'informations erronées sur une plateforme." conclut-t-il

De fausses affirmations se répandent à propos de l'attaque de la résidence de Chavez par les États-Unis

Outre les images trompeuses, de fausses affirmations selon lesquelles les forces américaines auraient frappé le mausolée de l'ancien président vénézuélien Hugo Chavez ont proliféré en ligne dans plusieurs langues, et ont même été partagées par le président colombien Gustavo Petro.

L'une d'entre elles prétend montrer le mausolée bombardé par l'armée américaine lors de son opération de capture.

Toutefois, comme l'indique Tal Hagin, la photo de droite est une image manipulée par l'intelligence artificielle à partir d'une photo réelle du mausolée datant de 2013, à laquelle les destructions ont été artificiellement ajoutées.

La Fondation Hugo Chavez elle-même a posté lundi sur Instagram une vidéo montrant le bâtiment intact avec une vidéo d'un téléphone indiquant la date de dimanche.