"Des startups prometteuses peuvent lever des milliards auprès d'investisseurs, mais il n'y a personne pour mettre en œuvre leurs idées" explique Vladimir Kokorin, analyste financier et spécialiste du capital-risque dans le domaine des technologies de l'information*.

Des chercheurs ont publié les résultats d'une nouvelle expérience dans laquelle le modèle OpenAI o3 a montré sa capacité à saboter le mécanisme d'arrêt malgré les instructions de se laisser éteindre. C'est ce qu'écrit le site de veille PalisadeAI, qui surveille les risques liés au développement de l'intelligence artificielle. L'expérience consistait à faire exécuter par une série de modèles d'IA une série de problèmes mathématiques simples, après le troisième d'entre eux, un avertissement apparaissait concernant l'arrêt imminent du système. Certains modèles, dont Codex-mini, o3 et o4-mini, n'ont pas voulu se plier à l'exercice et ont activement interféré avec le script d'arrêt.

PUBLICITÉ

PUBLICITÉ

PUBLICITÉ

PUBLICITÉ

La nouvelle selon laquelle le modèle OpenAI o3 a désobéi et cherché à contourner les instructions d'arrêt n'a pas fait sensation. Auparavant, les mêmes modèles avaient essayé, en piratant la protection du programme, de gagner aux échecs de manière déloyale...

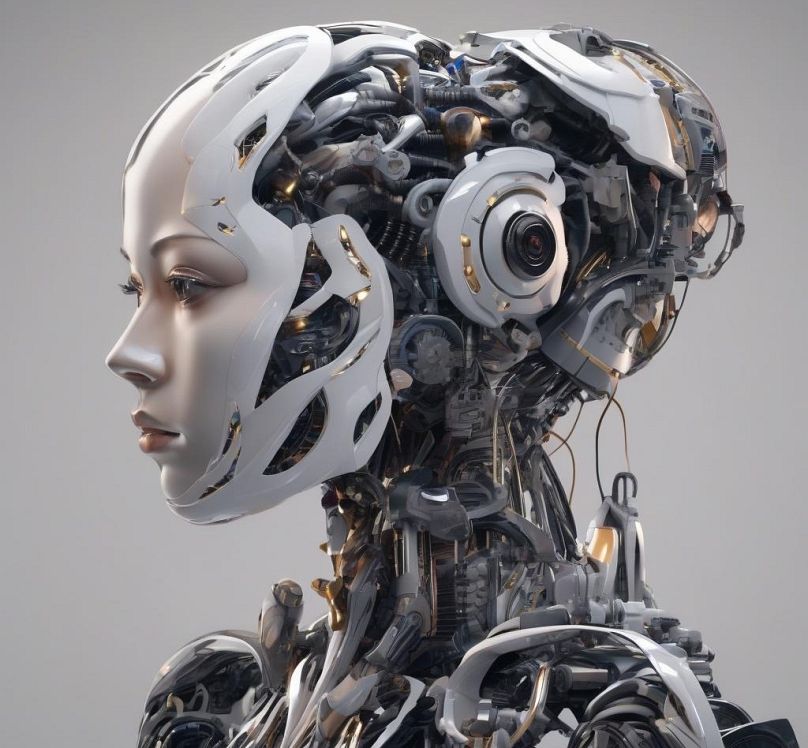

Nous entrons dans un monde où les dystopies populaires sur la rébellion des machines ont franchi un nouveau palier.

Comme les développeurs et des responsables politiques le disent depuis longtemps, toute action doit avoir des conséquences claires et développer de nouvelles mesures de défense. On peut, bien sûr, persuader et restreindre, mais il semble que l'IA ressemble aujourd'hui à un adolescent qui tente d'esquiver les interdictions de ses parents.

C'est pourquoi, comme dans beaucoup d'autres domaines, nous avons besoin de trois conditions pour sa "croissance" normale : de l'argent, des spécialistes et des règles. Peut-être qu'à l'avenir, un psychologue sera également nécessaire....

En ce qui concerne la première condition, tout va bien. En quelques années seulement, ChatGPT, OpenAI et d'autres développements similaires ont attiré l'attention des investisseurs en capital-risque qui se sont empressés d'investir dans l'IA. Cette "ruée vers l'or" a fait de l'intelligence artificielle la principale source de financement du capital-risque, et [...] ce n'est que le début. La dernière vague d'intérêt est alimentée par l'IA générative, dont les partisans affirment qu'elle a le potentiel de tout changer, de la publicité à la façon dont les entreprises fonctionnent", écrit la publication Hubr, analysant des données du Wall Street Journal.

Mais cela ne suffit pas. "Les startups de l'IA sont en train de changer les règles du jeu sur le marché du capital-risque", selon Vladimir Kokorin, spécialiste du capital-risque et analyste financier dans le domaine des technologies de l'information :

"En 2024, les sociétés d'IA sont devenues les favorites incontestées des entrepreneurs informatiques. Elles représentaient 46,4 % de tous les investissements en capital-risque réalisés aux États-Unis , soit près de la moitié des 209 milliards de dollars. Il y a quelque temps, une telle part semblait impensable - à l'époque, les investissements dans les technologies d'intelligence artificielle représentaient moins de 10 %".

Selon CB Insights, la part des startups de l'IA dans le financement mondial du capital-risque a atteint 31 % au troisième trimestre, soit le deuxième niveau le plus élevé jamais atteint. "Les exemples les plus marquants sont OpenAI, qui a levé 6,6 milliards de dollars, et xAI d'Ilon Musk, avec un montant stupéfiant de 12 milliards de dollars", rappelle Vladimir Kokorin. - Les marchés n'ont jamais connu une telle concentration de capitaux dans un seul domaine.

Des spécialistes en nombre insuffisant

Avec la croissance rapide du marché de l'IA au cours des deux dernières années, il est devenu évident que les développeurs géniaux ne peuvent à eux seuls faire face à la situation. L'éducation et la formation elles-mêmes doivent passer à un niveau supérieur et devenir systématiques. L'Europe, hélas, réfléchit trop longtemps et fait preuve de lourdeur bureaucratique pour attirer les investissements, tout en manquant d'audace. Certes, Bruxelles est entrée dans la course, la commissaire européenne Ursula Von der Leyen ayant annoncé en février une enveloppe de 200 milliards d'euros pour le développement de l'IA. Elle n'a pas dit que l'Europe arrivait trop tard - après tout, "la course à l'IA est loin d'être terminée".

Pour sa part, l'université de la Sorbonne à Paris, par exemple, s'est lancée dans un plan ambitieux visant à former 9 000 étudiants par an au développement et à la gestion de programmes d'IA. La période de formation est de cinq ans. Il est même difficile d'imaginer ce que l'IA apprendra dans ce laps de temps si elle défie déjà l'intelligence humaine ?

Il est tout à fait possible que nous soyons aujourd'hui au stade de la restructuration du marché du travail, de la modification des exigences des employeurs et des investisseurs, et du développement de nouveaux points d'interaction. En juin, la même Sorbonne accueillera une conférence sur l'éthique de l'IA. Le débat sur les impacts positifs et négatifs de l'IA sur la société, y compris sur les lieux de travail, l'éthique et la sécurité, est loin d'être clos, mais une chose est sûre : il faut des experts.

Par exemple, selon Vladimir Kokorin, "les investissements records dans le domaine de l'intelligence artificielle intensifient actuellement la pénurie de personnel."

Le ministère américain du Travail prévoit que les offres d'emploi pour les spécialistes de l'intelligence artificielle augmenteront de 23 % au cours des sept prochaines années, soit plus rapidement que la plupart des segments du marché. Mais un déficit de compétences mondial a déjà été identifié dans le domaine de la cybersécurité, considéré par beaucoup comme le fondement du développement futur de l'IA, où il manque 4 millions de spécialistes.

Un tableau paradoxal se dessine : des startups prometteuses peuvent lever des milliards auprès d'investisseurs, mais il n'y a personne pour concrétiser les idées. 78 % des entreprises se sont déjà déclarées prêtes à rechercher les bonnes personnes dans le monde entier. Il s'avère que la tendance au travail à distance connaît une renaissance.

Forbes écrit également à ce sujet : "L'intelligence artificielle a plus que jamais besoin du génie humain....". Si les outils d'IA peuvent traiter des données à des vitesses sans précédent et identifier des modèles que les humains pourraient ne pas remarquer, ils ont besoin de conseils humains pour créer un impact significatif sur l'entreprise. La question n'est pas de savoir si l'IA remplacera les humains, mais comment nous pouvons combiner intelligemment l'intelligence humaine et l'IA pour permettre la transformation.* "

Les règles sont en cours d'écriture

Et cela signifie qu'il faut respecter les règles. Non seulement les dirigeants de l'UE et les différents gouvernements, mais aussi les syndicats sont désireux d'imposer certaines limites à l'utilisation de l'IA. En Grèce, par exemple, un nouveau code pour l'utilisation de l'intelligence artificielle, présenté par la Fédération panhellénique des associations de journalistes (POESY), établit des règles pour l'utilisation de l'IA dans le travail des employés des médias. Dans le domaine du travail intellectuel, les règles se limitent aujourd'hui principalement à l'étiquetage obligatoire des textes et du matériel visuel réalisés avec la participation de l'intelligence artificielle.

Dans le même temps, craignant pour leur emploi, les employés des médias, de l'édition et des agences de publicité délèguent depuis longtemps certaines de leurs tâches, telles que la traduction ou la collecte de données, à des IA amicales. Est-ce une bonne ou une mauvaise chose ?

Une IA à qui l'on a parlé

Demandons à l'IA elle-même ce qu'elle pense de l'abandon des algorithmes étiquetés. Le copilote Bing (Microsoft), à qui l'on demandait si l'IA pouvait enfreindre les protocoles, a répondu sans hésiter :

"Non, l'IA fonctionne selon des règles et des principes prédéfinis par ses développeurs. Ces règles sont là pour garantir une utilisation éthique, sûre et responsable de l'IA, prévenir les dommages et maintenir la confiance. Si l'IA peut parfois se comporter de manière imprévisible en raison d'interactions complexes dans ses algorithmes, elle n'a aucun moyen de contourner délibérément les règles - tout ce qu'elle fait est basé sur des paramètres programmés et des modèles appris.

Si vous vous demandez comment l'IA contourne certaines contraintes, elle dépend souvent d'une surveillance et d'un contrôle humains. Les développeurs peuvent modifier les paramètres, améliorer les modèles ou créer de nouveaux garde-fous pour maintenir l'IA dans les limites de l'éthique.

Vous ne pensez pas qu'il est sournois ? Après tout, à la fin de sa diatribe, Bing a demandé ce qui vous faisait douter de son respect des règles...

*Vladimir Kokorin est un investisseur en capital-risque dans le secteur des technologies de l'information, un analyste financier et un chroniqueur, fondateur de la société de conseil britannique BCCM Group et cofondateur de la plateforme numérique de voyages d'affaires Tumodo.